Table of Contents

Les serveurs

Définition

Le serveur est considéré comme le centre d’un réseau. C’est le cerveau du réseau.

Il est composé des mêmes sous-ensembles qu’un PC standard. Mais ces sous-ensembles sont beaucoup mieux optimisés:

- Il contient plus de mémoire vive

- Son contrôleur de disques est de très bonne qualité (SCSI, voire Wide ou Ultra Wide SCSI)

- Disques durs de très grande capacité

- Microprocesseur(s) de dernière génération

- Capacités de gestion de réseau

On peut dire qu’un serveur bénéficie des toutes dernières technologies informatiques.

Structure d’un serveur

- uP Sa puissance dépend du type de serveur utilisé

- RAM Une quantité élevée de mémoire peut améliorer les performances du serveur. Un minimum de 32Mb est requis.

- Disque La taille des disques durs dépend aussi du type de serveur.

La configuration actuelle du serveur de l’ETI est la suivante :

- Windowsâ NT Server 3.51

- Processeur Intel Pentium™ cadencé à 133 MHz

- 32Mb de RAM qui seront prochainement upgradés à 96Mb.

- 4 disques dur SCSI de 4Gb en configuration RAID 5

Types de serveurs

Il existe 3 types de serveurs.

- Serveur de fichier S’occupe de la gestion des fichiers. Il faut pour cela un très bon sous-système disque (contrôleur et disques), au moins 32 MB de RAM et une carte réseau très performante.

- Serveur d’application Il contient les applications que les utilisateurs du réseau peuvent utiliser. Tous les traitements des logiciels se fait sur le serveur donc la rapidité du m P et la quantité de RAM (au moins 64MB) sont primordiales.

- Serveur d’impression C’est lui qui gère les queues d’impression. Ce type de serveur est souvent couplé avec un serveur de fichiers ou un serveur d’applications car il ne demande pas un sous-système très performant.

Il est possible d’installer ces 3 types de serveurs sur la même machine, mais son optimisation devient alors difficile et le risque de pannes augmente.

Interfaces

En règle générale, l’interface retenue pour les serveurs est le SCSI. Elle offre plusieurs avantages :

- chaînage des unités

- paramétrage facilité des unités (ID, terminaison)

- connexion maximale de 7 périphériques ( 6 unités + 1 contrôleur SCSI)

- bus de communication indépendant

Le standard SCSI (Small Computer System Interface) permet d’interconnecter plusieurs périphériques différents comme des CD-ROMS, Disques dur, scanners, streamers, etc..

Les périphériques connectés sur le contrôleur SCSI utilisent le bus de communication du contrôleur et non pas celui du PC. Ceci a pour avantage de ne pas trop charger le bus du PC lorsque les périphériques SCSI communiquent entre eux.

Fiabilité et sécurité d’un serveur

Généralités

Une des fonctions majeures d’un serveur, est d’éviter la perte des données. Pour cela, il existe plusieurs moyens de prévention qu’un administrateur de réseau doit utiliser:

- Backup

- Alimentation de secours

- Système disque à tolérance de pannes

- Multiprocessing

La première mesure de sécurité à prendre, est d’effectuer régulièrement des sauvegardes (backup) du système, des données et de tout ce qui est essentiel au bon fonctionnement du serveur et du réseau. L’idéal dans ce cas est d’effectuer ces sauvegardes une fois par jour, généralement la nuit, pendant que le serveur n’est pas ou est très peu utilisé.

Ces sauvegardes sont enregistrées sur des bandes DAT avec un streamer à la norme SCSI.

Une autre source d’erreur peut être une coupure de courant, ou des surtensions. Elle peuvent être très ennuyeuse selon le type de serveur car cela peut endommager l’alimentation du serveur et entraîner un arrêt du réseau plus ou moins prolongé. Pour éviter ces désagréments, on peut brancher le serveur sur une voir plusieurs alimentations sans coupures (appelées UPS). Le principe de fonctionnement d’un UPS est de prendre en charge l’alimentation de la machine pendant l’arrêt du secteur, et de supprimer de ce dernier les parasites qui pourraient apparaître. Il existe plusieurs types d’UPS allant de la simple batterie à petite autonomie au système à plusieurs batteries intelligentes capables de filtrer le signal du secteur afin d’éviter des fluctuations du courant. En cas de coupure d’alimentation, un signal est envoyé de l’UPS vers le serveur. Lorsque le serveur reçoit ce signal, il arrête toutes les applications en cours d’utilisation et referme tous les fichiers ouverts. Cela permet de ne pas perdre de données sur le serveur.

Le système RAID

Le système RAID est un système à tolérance de pannes. Il permet de regrouper plusieurs disques pour n’en former qu’un seul. Ceci améliore la fiabilité car il faudrait que plusieurs disques tombent en panne en même temps pour que des données soit perdues.

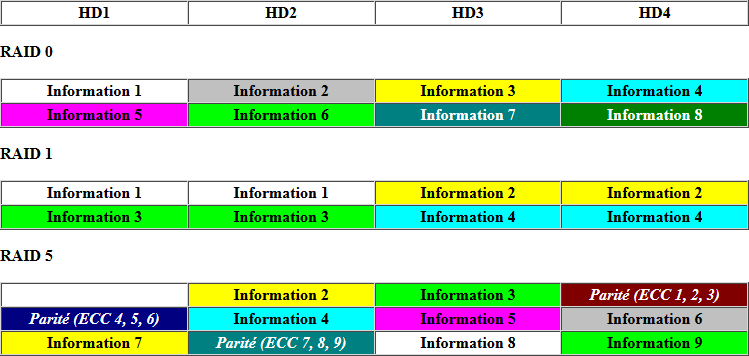

Il existe plusieurs niveaux de RAID mais les plus souvent retenus sont le RAID 0, le RAID 1 et le RAID 5.

| RAID 0 | Attention, RAID 0 n’est pas un système à tolérance de pannes, il améliore seulement le taux de transfert ! |

|---|---|

| Les informations sont réparties sur plusieurs disques sans aucun contrôle de parité. Il faut au minimum 2 disques | |

| Avantage: très bonnes performances puisque l’information est découpée sur plusieurs disques. Les disques vont traiter indépendamment et pratiquement en parallèle leur morceau de donnée avant de le transmettre au bus. | |

| Inconvénient: si un des disques tombe en panne, il est impossible de récupérer les données inscrites. De ce fait toutes les données sont perdues. | |

| RAID 1 | Il existe deux techniques du RAID 1 : le mirroring et le duplexing. Dans le premier cas, on utilise un contrôleur et dans le second on utilise deux contrôleurs. Mais le principe de base de ces deux techniques est de faire la copie exacte du premier disque sur le second. De ce fait, on se retrouve avec deux disques parfaitement identiques. Il faut un nombre de disques pair, deux au minimum. |

| Avantage: gain en sécurité. Si un disque lâche, on a toujours le second qui prend la main jusqu'à réparation du premier. Il est possible de recopier les informations du second disque sur le premier, même en cours de fonctionnement du serveur. Bien entendu les performance du serveur seront plus faibles pendant la recopie du disque. | |

| Inconvénient: puisqu’il faut absolument une paire de disque, la solution est chère. Puisqu’avec deux disques de 2Gbytes, on n’aura que 2Gbytes de capacité disque utilisable. | |

| RAID 5 | C’est une technique qui ressemble au RAID 0 mais la grande différence est que cette fois, il y a un contrôle de parité. Les données sont donc toujours réparties sur tous les disques. Il y a en plus un calcul de parité qui ce fait à l’écriture et la lecture des donnés. Cette parité est aussi répartie sur tous les disques. Il faut au minimum 3 disques. |

| Avantage: Si un disque tombe en panne, grâce au contrôle de parité on peu le remplacer et reconstruire les données plus ou moins rapidement selon la qualité du contrôleur. C’est aussi une solution moins chère que le RAID 1 car la capacité de stockage est de N disques - 1, soit au minimum 66%. C’est une solution très intéressante lorsqu’on a beaucoup de disques. | |

| Inconvénient: Le temps de reconstruction des données peut être assez lent. Il faut à chaque fois recalculer la parité des données. |

Pour tous ces niveaux de RAID, on peut utiliser un contrôleur standard ou un contrôleur RAID.

- Contrôleur standard: La gestion RAID se fait par logiciel (avec Windows NT™ par exemple). C’est une solution peu onéreuse mais lente

- Contrôleur RAID: La gestion est effectuée par le matériel: il y a un processeur dédié et de la mémoire sur le contrôleur pour gérer le RAID. Cette solution est totalement indépendante du système d’exploitation. Elle est très rapide mais malheureusement son prix est encore élevé.

Le multiprocessing

Le multiprocessing englobe plusieurs technique qui consistent à utiliser plusieurs processeurs en parallèle pour effectuer des taches qui demande une grande puissance de calcul, ou pour parer à d’éventuelles défaillances du processeur, ce qui est assez rare.

SMPNSP

On utilise 2 processeurs qui se partagent la mémoire, le bus, les disques etc.. Il faut pour cela que le système d’exploitation puisse gérer plusieurs processeurs (WINDOWS NT™ ou Novell avec SMP) et que bien sur les programmes soient développés afin d’utiliser pleinement cette technique. Malgré cela, il y a un risque de saturation du bus ou de la mémoire.

Il existe alors une variante de cette technique. Chaque processeur a sa propre mémoire. De ce fait, les processeurs ne vont pas polluer la mémoire des autres. Le système est donc plus stable. Cette technique est utilisée dans les serveurs de très haut de gamme car c’est une solution onéreuse.

Clusters

On relie des machines qui peuvent être de milieux de gamme par des connexions à très haut débit. On gère ces machines de manière à ce que l’utilisateur final ne les aperçoive que comme une seule et unique machine. C’est une solution moins onéreuse mais dont la tolérance aux pannes est moins bonne.

Conseils d'achat

Pour terminer ce chapitre sur les serveurs, voici quelques conseils utiles pour l’achat d’un serveur.

Il faut toujours bien penser à la tache que le serveur doit accomplir, au type de réseau installé, au nombre de stations connectées et donc aussi à l’encombrement du réseau et à la capacité du serveur à gérer cette surcharge.

Pour éviter une saturation du réseau et du serveur qui engendrerai des temps d’attente trop longs et désagréables aux utilisateurs, il faut :

- Avoir de bons disques avec de la mémoire cache

- Un contrôleur disque rapide contenant également de la mémoire cache

- Utiliser un contrôleur multicanaux afin d’éviter une surcharge du bus du contrôleur.